Leave-One-Out Cross Vallidation과 K-fold Cross Validation

IT/Artifical Intelligence 2020. 1. 19. 17:53

생성된 모델이 잘 만들어졌는지 확인하는 방법, 즉 모델의 적합성을 확인하기 위한 방법으로 Cross Validation가 있다. Cross Validation은 크게 두가지 방법이 있으며 첫번째 방법은 Leave-One-Out Cross Validation(LOOCV), 두번째 방법은 K-fold Cross Validation이다.

1. Leave-One-Out Cross Validation

n개의 데이터가 있을 경우 1개를 테스트 데이터로, n-1개를 트레이닝 데이터로 활용합니다.

1부터 100까지 데이터가 있다고 가정하면 테스트 데이터를 1에서부터 100까지 한번씩 사용하게 되어 총 n 번의 검증을 거치게 된다.

예시) 첫번째 검증 : 테스트 데이터 1, 트레이닝 데이터 2~100

두번째 검증 : 테스트 데이터 2, 트레이닝 데이터 1, 3~100...

백번째 검증 : 테스트 데이터 100, 트레이닝 데이터 1~99

데이터의 개수만큼 반복해야하기 때문에 시간이 오래 소요된다는 단점이 있다.

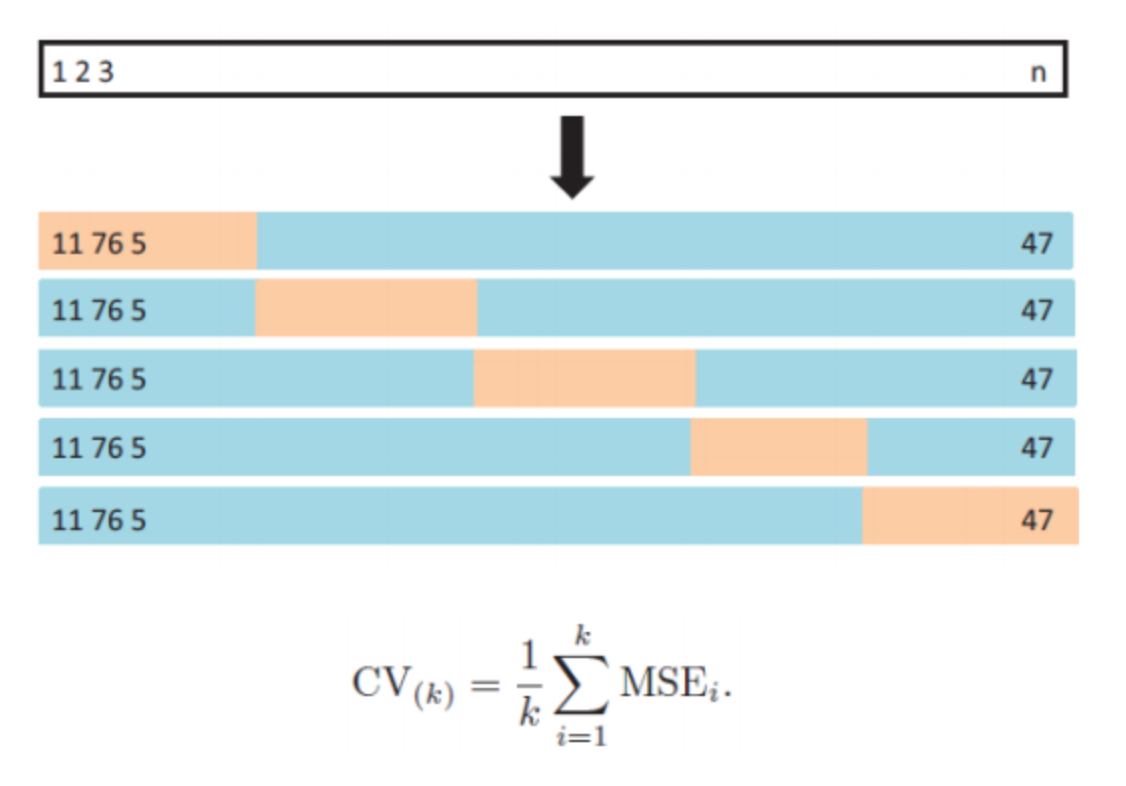

2. K-fold Cross Validation

n개의 데이터가 있을 경우 데이터를 k개의 그룹으로 나누고 1개를 그룹을 테스트 데이터로, k-1개를 트레이닝 데이터로 활용합니다.

Leave-One-Out Cross Validation과의 차이점은 데이터를 그룹으로 나누어 데이터를 크게 핸들링하기 때문에 VOOCV 방법보다 시간이 적에 소요된다는 장점이 있습니다.

WRITTEN BY

- Dukejin

If you don't walk today, you will have to run tomorrow. Try hard, Try hard!

,